Die internationale EY-Organisation besteht aus den Mitgliedsunternehmen von Ernst & Young Global Limited (EYG). Jedes EYG-Mitgliedsunternehmen ist rechtlich selbstständig und unabhängig und haftet nicht für das Handeln und Unterlassen der jeweils anderen Mitgliedsunternehmen. Ernst & Young Global Limited ist eine Gesellschaft mit beschränkter Haftung nach englischem Recht und erbringt keine Leistungen für Mandanten.

- Beim Einsatz von KI-Systemen stehen Unternehmen heute bereits vor der Herausforderung, wesentliche rechtliche Anforderungen zu meistern. Dazu gehören Datenschutz, Datenmanagement, IP-Prüfung und -Verwaltung sowie der Schutz von Geschäftsgeheimnissen.

- Spätestens mit der geplanten EU-KI-Verordnung, die voraussichtlich Anfang/Mitte 2026 in Kraft treten wird, werden Unternehmen einer Vielzahl regulatorischer Anforderungen gegenüberstehen. Ziel ist es, den Schutz grundlegender Rechte natürlicher Personen und den Einsatz von KI in Einklang zu bringen. Besondere Aufmerksamkeit gilt hierbei den sogenannten Hochrisiko-KI-Systemen.

Einleitung

Seit der Veröffentlichung des Chatbots ChatGPT ist künstliche Intelligenz (KI) fester Bestandteil unseres Alltags geworden. Unternehmen möchten das Potenzial der KI nutzen und sie wertschöpfend in ihrem Betrieb einsetzen. Aktuelle Beispiele sind die Verwendung von Generative AI (GenAI) als Chatroboter für Kundenanfragen und im Kundensupport oder die Nutzung von „Co-Pilot“-Anwendungen für Programmierer, die Programmcodes erstellen, überprüfen und optimieren können. Die Einsatzmöglichkeiten scheinen grenzenlos und vielfältig.

KI bezieht sich grundlegend auf die Fähigkeit von Maschinen, Aufgaben auszuführen, die normalerweise menschliche Intelligenz erfordern würden. Dies umfasst verschiedene Technologien, die darauf abzielen, Systeme zu entwickeln, die Wahrnehmung, Lernen, Problemlösung und Entscheidungsfindung nachahmen oder simulieren können.

Jedoch bringen diese Chancen im wirtschaftlichen Umfeld auch Risiken mit sich. Je nach Verwendungszweck der KI können Risiken für öffentliche oder private Interessen und für grundlegende Rechte natürlicher Personen entstehen. Dazu gehören etwa persönlichkeitsverletzende Falschdarstellungen. In einem Fall erfand ChatGPT z. B. einen sexuellen Belästigungsskandal und nannte einen echten Juraprofessor als Beschuldigten. Es gibt auch eine Vielzahl von Klagen gegen OpenAI und andere GenAI-Anbieter, bei denen Autoren, Künstler und andere Kreative den Anbietern vorwerfen, ihre KI-Modelle ohne ihre ausdrückliche Einwilligung mit ihren Werken trainiert und damit Urheberrechtsverletzungen begangen zu haben.

Um solchen Risiken und möglichen schwerwiegenderen Schäden für natürliche Personen vorzubeugen, hat sich der Europäische Gesetzgeber für eine Regulierung entschieden – die geplante EU-KI-Verordnung.

Die EU-KI-Verordnung und ihre zukünftigen Anforderungen

Die Europäische Union arbeitet derzeit (Stand: September 2023) an einer Gesetzgebung für KI, die EU-KI-Verordnung (KI-VO). Bisher liegen nur Entwurfsfassungen der Europäischen Kommission, des Rats der Europäischen Union und des Europäischen Parlaments vor. Die endgültige Fassung wird gerade im sogenannten Trilog des europäischen Gesetzgebungsverfahrens verhandelt. Der Zeitplan für die Fertigstellung und Umsetzung des Gesetzes ist noch nicht sicher und es könnte bis Mitte 2024 dauern, gefolgt von einer Umsetzungsfrist von 18 bis 24 Monaten.

Eine der kontrovers diskutierten Fragen ist, wie KI im Gesetz definiert werden soll. Es ist absehbar, dass eine breite und zukunftsfähige Definition gewählt wird, die den schnellen Entwicklungen in der KI-Technologie und auf dem KI-Markt gerecht wird (vgl. COM [2021] 206 final, Abschnitt 5.2.1, https://eur-lex.europa.eu/legal-content/DE/TXT/HTML/?uri=CELEX:52021PC0206).

Die vier Risikokategorien

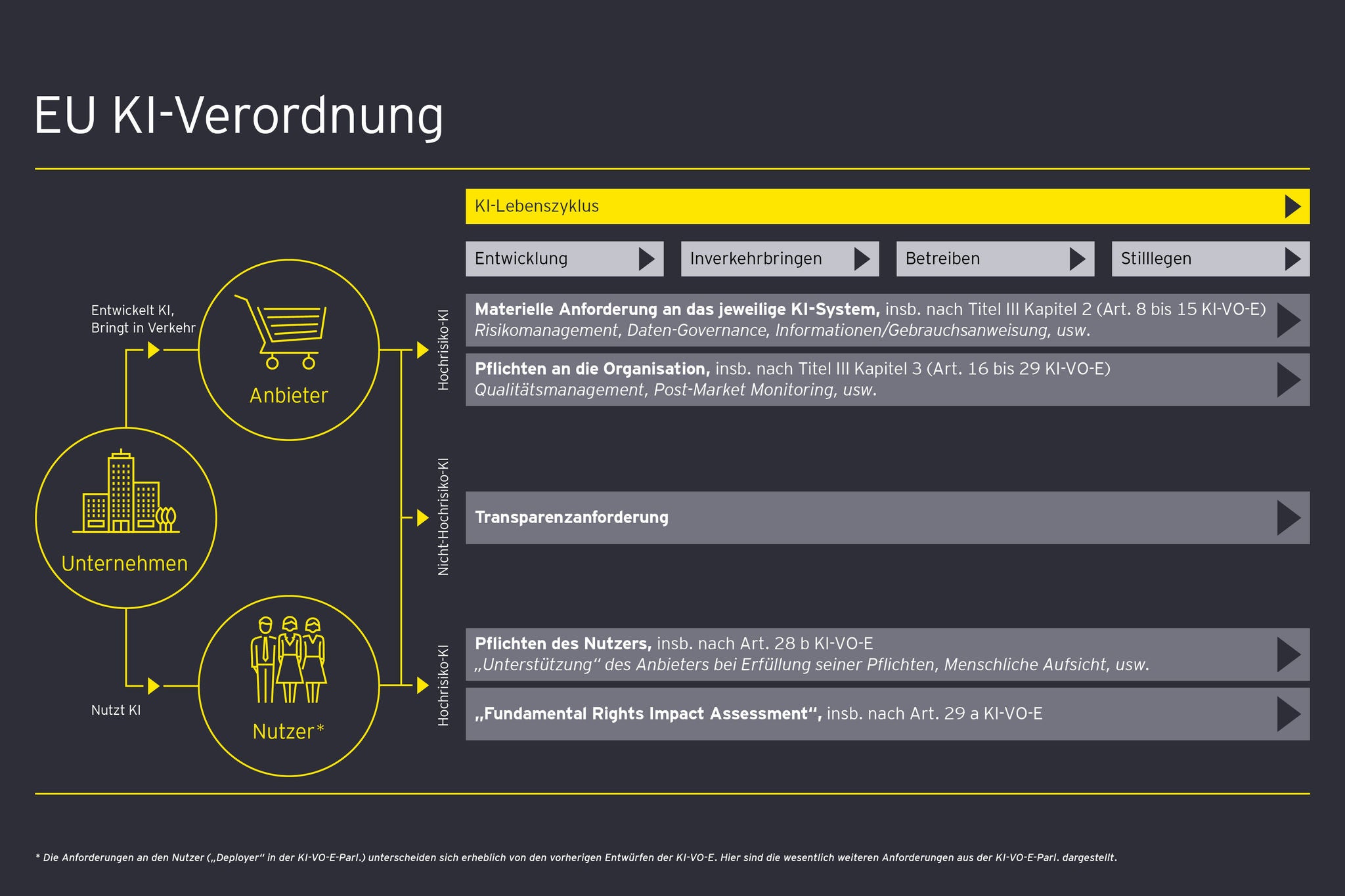

In den verschiedenen Verordnungsentwürfe sind übereinstimmend vier Risikokategorien für KI-Systeme vorgesehen, basierend auf dem potenziellen Schaden, den das jeweilige KI-System verursachen kann. Aus der entsprechenden Risikokategorie leiten sich Einhaltungsanforderungen ab. Verantwortlich für die Einhaltung sind der Anbieter und der Nutzer. Der Anbieter ist regelmäßig der Entwickler und Inverkehrbringer des KI-Systems. Hingegen ist der Nutzer regelmäßig der Betreiber des KI-Systems (die Entwürfe sprechen hier von „nutzen“).

- Inakzeptables Risiko: Hier handelt es sich um KI-Systeme, die als unannehmbares Risiko für die Sicherheit, die Rechte und die Existenzgrundlagen von Einzelpersonen angesehen werden und als Folge per se verboten sein werden. Diese Kategorie umfasst KI-Systeme, die in kritischer Infrastruktur, wesentlichen öffentlichen Diensten, Strafverfolgung und Migration verwendet werden (können/sollen).

- Hochrisiko-KI-System: In diese Kategorie fallen KI-Systeme, die voraussichtlich erheblichen Schaden verursachen oder die grundlegenden Rechte von Menschen beeinträchtigen werden. Dazu zählt KI in Bereichen wie Beschäftigung, Bildung, Zugang zu wesentlichen öffentlichen Diensten und Strafverfolgung. Beispiele sind KI-basierte Bewerber- und HR-IT-Lösungen, Systeme zur Vergabe von Schulnoten oder Bewertungen, Bonitätsprüfung und Gesichtserkennung im öffentlichen Raum. Fällt ein KI-System in diese Kategorie, so folgen daraus sehr weitreichende Anforderungen und tiefgreifende Einschränkungen.

- Nicht-Hochrisiko-KI-System: Diese Kategorie umfasst KI-Systeme mit potenziellen Risiken, die jedoch nicht in die ersten beiden Kategorien fallen. Dazu gehören KI-Systeme, die in nichtkritischen öffentlichen Diensten oder Anwendungen im privaten Sektor eingesetzt werden, die die Rechte oder die Sicherheit einer Einzelperson beeinträchtigen können, wenn auch in geringerem Maße. Hier haben Anbieter und Nutzer insbesondere für Transparenz durch geeignete Maßnahmen zu sorgen.

- System mit minimalem oder keinem Risiko: KI-Systeme, die in keine der oben genannten Kategorien fallen, unterliegen voraussichtlich keinen Anforderungen aus der KI-VO.

Mit dem Verordnungsvorschlag des Europäischen Parlaments hat auch die GenAI Einzug in die geplante Regulierung gefunden. GenAI ist ein KI-System, das basierend auf dem, was es aus einer riesigen Menge von Daten gelernt hat, menschenähnliche Inhalte generieren kann, etwa Bilder, Musik oder Text. Es verwendet Algorithmen, um die Muster in den Daten zu verstehen und zu imitieren und neue Inhalte zu generieren.

Hochrisiko-KI-Systeme

Die Anforderungen an Hochrisiko-KI-Systeme betreffen den gesamten Lebenszyklus des KI-Systems: Entwicklung, Inverkehrbringen, Betrieb und Stilllegen.

Wichtig dabei ist, dass es zunächst materielle Anforderungen an das jeweilige Hochrisiko-KI-System selbst gibt. Daneben werden Pflichten an die Organisation des Anbieters des KI-Systems gestellt. Zentral für jedes Hochrisiko-KI-System ist dabei das Risikomanagement, für das ermittelt werden muss, welche individuellen Risiken mit dem Einsatz des jeweiligen Systems einhergehen (vgl. Art. 9 KI-VO-E). Für Organisationen steht insbesondere ein geeignetes Qualitätsmanagement im Mittelpunkt der Pflichten. Danach sind entsprechende Konzepte, Verfahren und Systeme für sämtliche materiellen Anforderungen an das Hochrisiko-KI-System zu definieren, umzusetzen und aktiv nachzuweisen (vgl. Art. 17 Abs. 1 KI-VO-E).

Aktuelle Herausforderungen für den Einsatz von GenAI

Neben der zukünftigen EU-KI-Verordnung gibt es bereits vielfältige rechtliche und regulatorische Anforderungen für den Einsatz von KI, insbesondere bei GenAI. Dazu gehören Anforderungen

- im Bereich des Datenschutzes,

- zum Schutz von Geschäftsgeheimnissen, Urheberrechten und geistigem Eigentum (IP),

- im Bereich des Verbraucherschutz- und des Vertragsrechts sowie

- in Bezug auf arbeitsrechtliche Mitbestimmungsrechte des Betriebsrats.

Weitere Informationen dazu finden Sie in unserem EY Law KI-Guidebook „Generative AI in der Rechtsabteilung. Ein Leitfaden zum juristischen Einsatz von ChatGPT & Co.“ ab Seite 7.

Fazit und Handlungsempfehlung für Unternehmen

Beim Einsatz von KI-Systemen müssen Unternehmen schon heute wesentliche rechtliche Anforderungen und Herausforderungen meistern. Hierbei können sie idealerweise auf bestehende Managementsysteme zurückgreifen, die den Umgang mit rechtlichen Anforderungen wie Datenschutz, Datenmanagement oder IP-Prüfung und Verwaltung regeln.

Spätestens mit Geltung der EU-KI-Verordnung Anfang/Mitte 2026 werden Unternehmen eine Vielzahl regulatorischer Anforderungen erfüllen müssen, um den Schutz grundlegender Rechte natürlicher Personen im Zusammenhang mit dem Einsatz von KI sicherzustellen. Dies gilt insbesondere für den Einsatz sogenannter Hochrisiko-KI-Systeme.

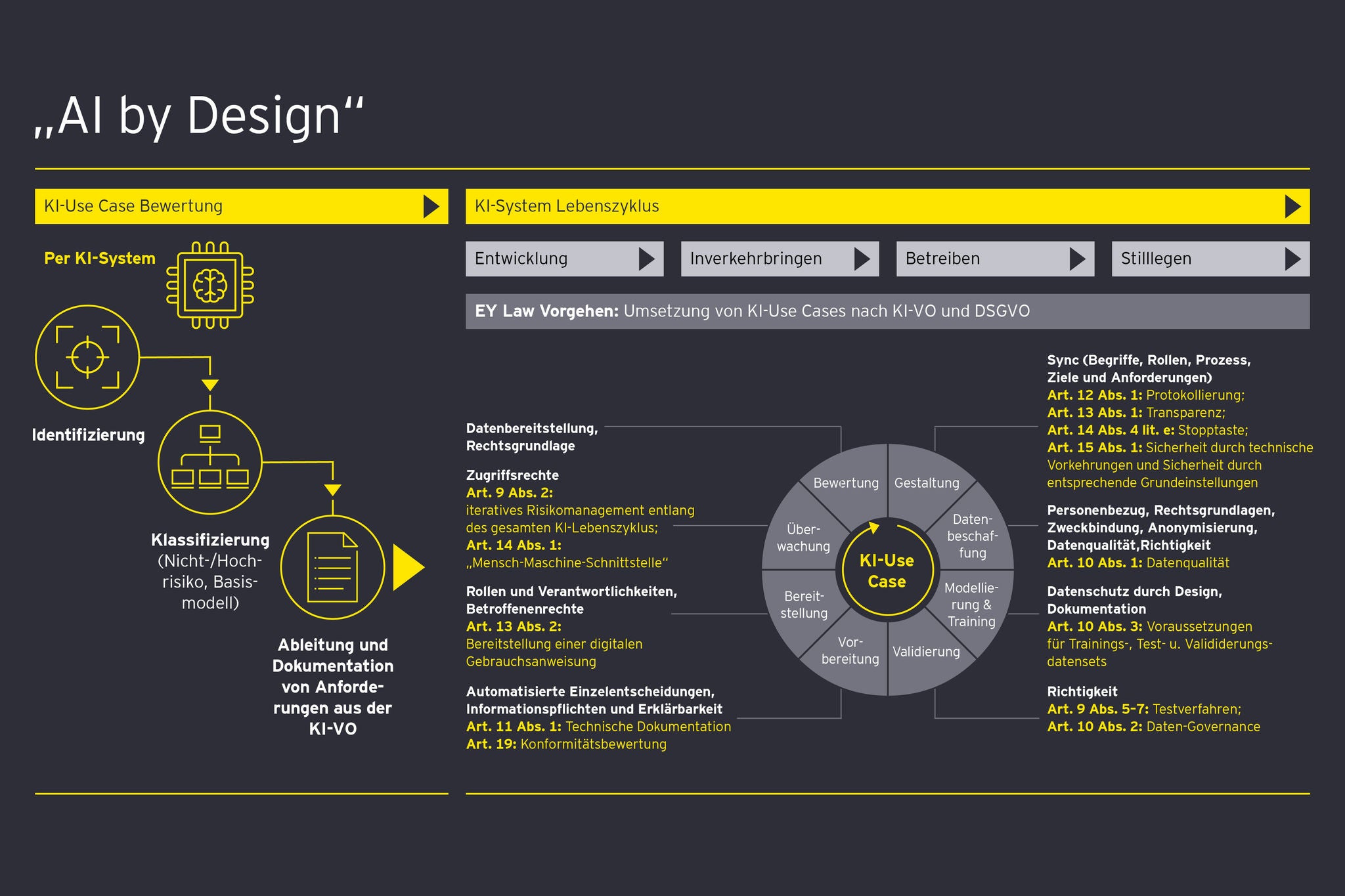

Unternehmen sollten daher umgehend eine KI-Governance etablieren. Diese Governance sollte in der Lage sein, alle KI-Use-Cases zu identifizieren, zu klassifizieren und zu dokumentieren. Unternehmen, die bereits KI-Systeme entwickeln, die höchstwahrscheinlich als Hochrisiko-Systeme eingestuft werden, sollten wichtige – wenn auch noch nicht endgültige – Anforderungen der KI-VO schon bei der Entwicklung berücksichtigen. Eine nachträgliche Anpassung wird in der Regel mit erheblichem Aufwand verbunden, wenn nicht sogar unmöglich sein. Dies gilt insbesondere für Anforderungen im Bereich Daten-Governance und Datenmanagement gemäß Art. 10 KI-VO-E. Sobald eine KI mit Daten und Informationen trainiert ist, ist es technisch äußerst schwierig, dies rückgängig zu machen oder Informationen zu entfernen. Dies kann problematisch sein, wenn sich nachträglich Urheberrechtsverletzungen ergeben oder die von der KI-VO geforderte Datenqualität nicht erreicht wird.

Unternehmen müssen daher heute und nicht erst morgen handeln, wenn sie die Chancen der künstlichen Intelligenz rechtskonform nutzen möchten.

Kontaktperson: Eric Meyer, Dipl. iur. oec. univ.

Direkt in Ihr E-Mail Postfach

Wir informieren Sie monatlich über aktuelle Themen insbesondere aus den Bereichen Arbeitsrecht, M&A, Gesellschaftsrecht, PE, Kartellrecht, Energierecht, Digital Law, Public Law, Public Mobility Law und Legal Process and Technology. Wenn Sie an unserem Newsletter und dem Law Quarterly Webcast interessiert sind, können Sie sich hier anmelden.